Anatomie

Définition

L'anatomie est le domaine de la biologie et la médecine qui étudie l'organisation structurelle des êtres vivants, y compris les processus, organes et tissus qui les constituent, l'apparence et position des différentes parties dont ils sont les substances, en intégrant leur emplacement et relations avec d'autres parties du corps.

L'anatomie (zootomie) avec une étude de morphologie :

L'anatomie quand elle concerne les animaux est plus précisément la zootomie. L'étude morphologique d'un chien illustre l'anatomie canine (des canidés) et peut être étendue à tous les quadrupèdes. Cette description anatomique est à la fois superficielle avec le tissu musculaire et squelettique avec les os.

Explications

Le terme anatomie est généralement utilisé de manière synonyme avec l'anatomie humaine, l'androtomie. Cependant, les mêmes structures et tissus peuvent être observés dans presque tout le règne animal, de sorte que le terme se réfère également à l'anatomie d'autres animaux, auquel cas le terme de zootomie est utilisé. D'autre part, la structure et les tissus des plantes sont de nature différente et sont étudiés par l'anatomie végétale.

Voir aussi l'article sur les directions anatomiques et positions.

Spécifiquement pour le poisson rouge, voir l'anatomie d'un poisson rouge, et pourquoi il existe autant de variétés (races) de poissons rouges.

Voir aussi la microanatomie (histologie).

Subdivisions spécialisées

Par anatomie, on définit l'étude scientifique de l'organisation des êtres vivants, ainsi que des relations entre leurs diverses composantes. On distingue :

- l'anatomie animale, y compris l'anatomie humaine ou l'anatomie des poissons;

- l'anatomie végétale, notamment d'une fleur avec l'anatomie d'une fleur;

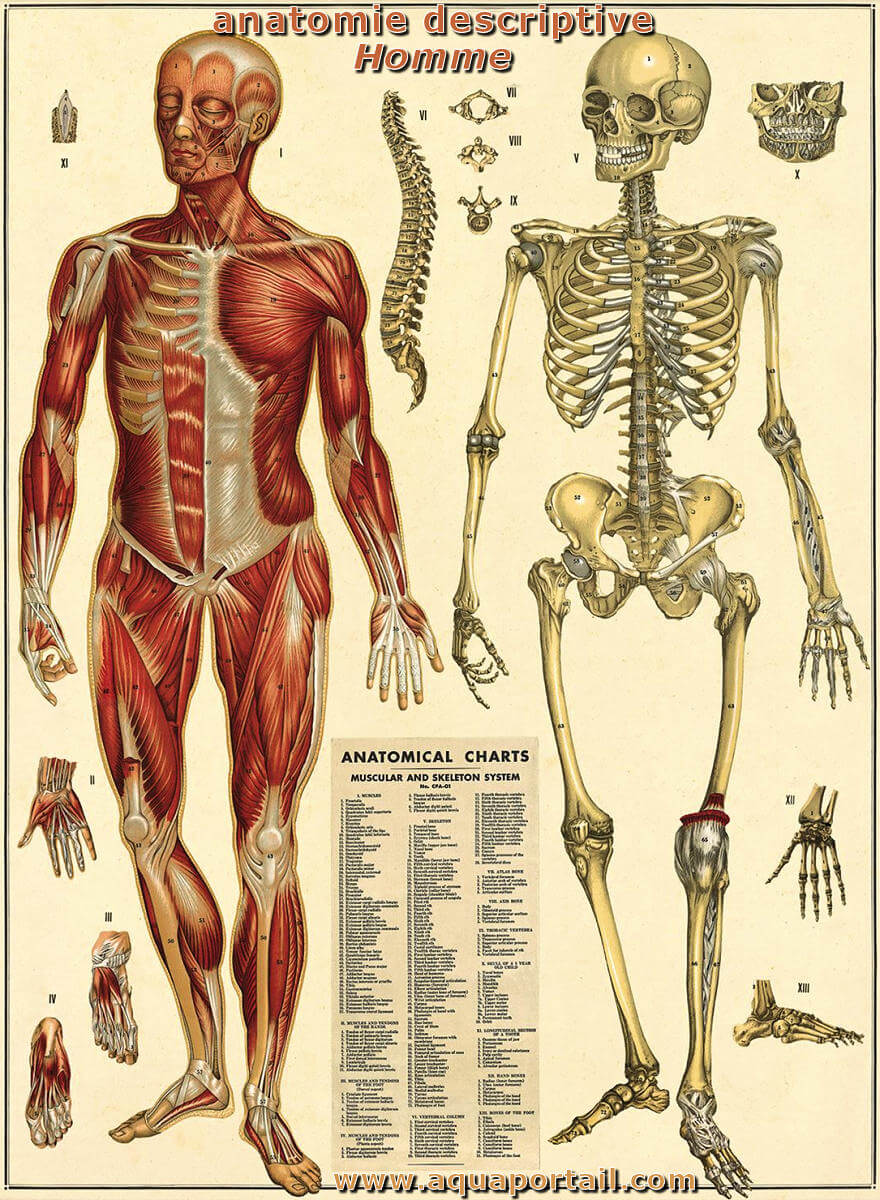

- l'anatomie descriptive macroscopique qui renseigne sur l'anatomie d'un organisme;

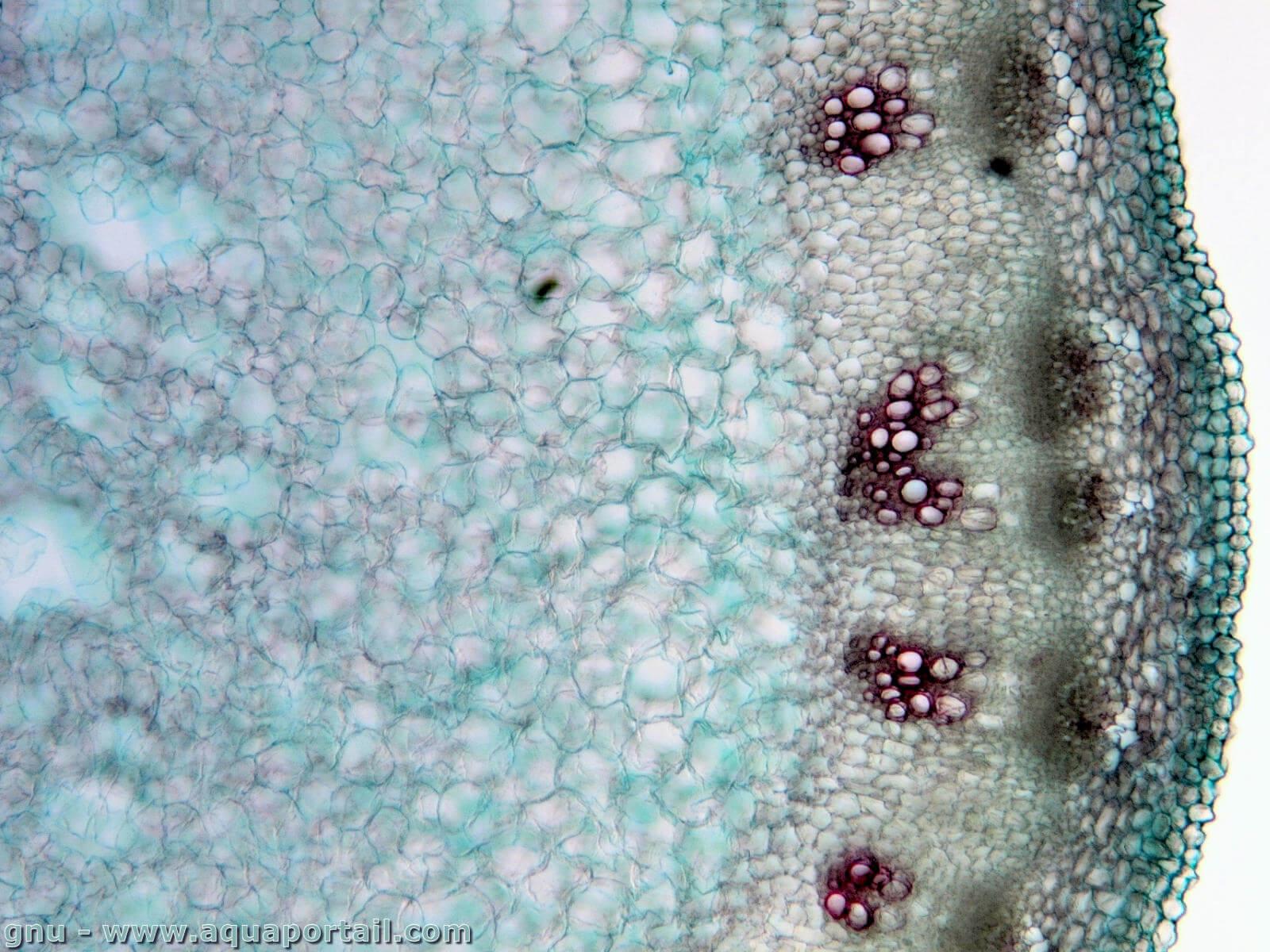

- l'anatomie descriptive microscopique qui étudie les structures à l'échelle cellulaire. Elle comprend la cytologie et l'histologie;

- l'anatomie du développement qui décrit les transformations d'un organisme de sa conception à son vieillissement;

- l'anatomie comparée qui s'attache à montrer les homologies et analogies entre différentes espèces;

- l'anatomie fonctionnelle.

Le spécialiste de l'anatomie est l'anatomiste. La desmologie est une partie de la la science de l'anatomie qui traite des ligaments. La brachyconie résulte d'un raccourcissement d'un cône vertébral, expression employée en anatomie osseuse. Une brachyconie prosotrope consiste en un raccourcissement du cône vertébral antérieur, en anatomie osseuse, et surtout en ichtyologie.

Des sciences auxiliaires complètent l'étude anatomique spécialisée et sont présentes dans chacune de ses branches en général :

- ostéologie : étude des os.

- arthrologie : étude des articulations.

- Myologie : étude des muscles.

- Angiologie : étude des vaisseaux sanguins (système vasculaire).

- Cardiologie : étude du coeur.

- splanchnologie : étude des viscères.

- Neurologie : étude des nerfs et du système nerveux central.

- Pneumologie : étude des voies respiratoires, du système respiratoire.

- Gastroentérologie : étude de tout ce qui recouvre le système digestif.

- endocrinologie : étude des glandes.

Voir aussi l'anatomie des poissons.

Évolution

L'anatomie se distingue de la physiologie et de la biochimie, qui étudient respectivement les fonctions de ces parties et les processus chimiques impliqués. Elle est liée à l'embryologie, à l'anatomie comparée, à la biologie évolutive et à la phylogénie, car ce sont les processus qui génèrent l'anatomie avec la morphologie. La discipline de l'anatomie peut être divisée en plusieurs branches, y compris l'anatomie macroscopique et microscopique.

L'anatomie macroscopique est l'étude de structures anatomiques suffisamment importantes pour être observées à l'oeil nu et englobe l'anatomie de la surface. L'anatomie microscopique est l'étude des structures à l'échelle microscopique et englobe l'histologie (l'étude des tissus) et l'embryologie (l'étude d'un organisme encore immature).

Le terme désigne à la fois la structure des organismes vivants et la branche de la biologie qui étudie ces structures, ce qui dans le cas de l'anatomie humaine devient l'une des sciences dites "fondamentales" ou "précliniques" de la médecine. L'anatomiste en est le spécialiste.

Bien que l'anatomie repose avant tout sur l'examen descriptif des organismes vivants, la compréhension de cette architecture implique maintenant un appariement avec la fonction, de sorte qu'elle est parfois confondue avec la physiologie (dans ce qu'on appelle l'anatomie fonctionnelle). Elle fait partie d'un groupe de sciences fondamentales appelé "sciences morphologiques" (biologie du développement, histologie et anthropologie), qui complètent leur domaine de connaissance avec une vision dynamique et pragmatique.

L'histoire de l'anatomie se caractérise par la compréhension progressive des fonctions des organes et des structures du corps humain. Au cours des derniers siècles, les méthodes d'observation ont évolué de manière significative, de la dissection des carcasses et des cadavres aux techniques modernes d'imagerie médicale, y compris la radiographie, l'échographie et l'imagerie par résonance magnétique.

Synonymes, antonymes

Voir tous les synonymes pour "anatomie".4 synonymes (sens proche) de "anatomie" :

0 antonyme (sens contraire).

Les mots ou les expressions apparentés à ANATOMIE sont des termes qui sont directement liés les uns aux autres par leur signification, générale ou spécifique.

Le mot ANATOMIE est dans la page 5 des mots en A du lexique du dictionnaire.

Mots en A à proximité

anapside anastomose anastomosée anastral anatife anatomieanatomie comparée anatomie d'une araignée anatomie d'une femme anatomie d'une feuille anatomie des plantes

En rapport avec "anatomie"

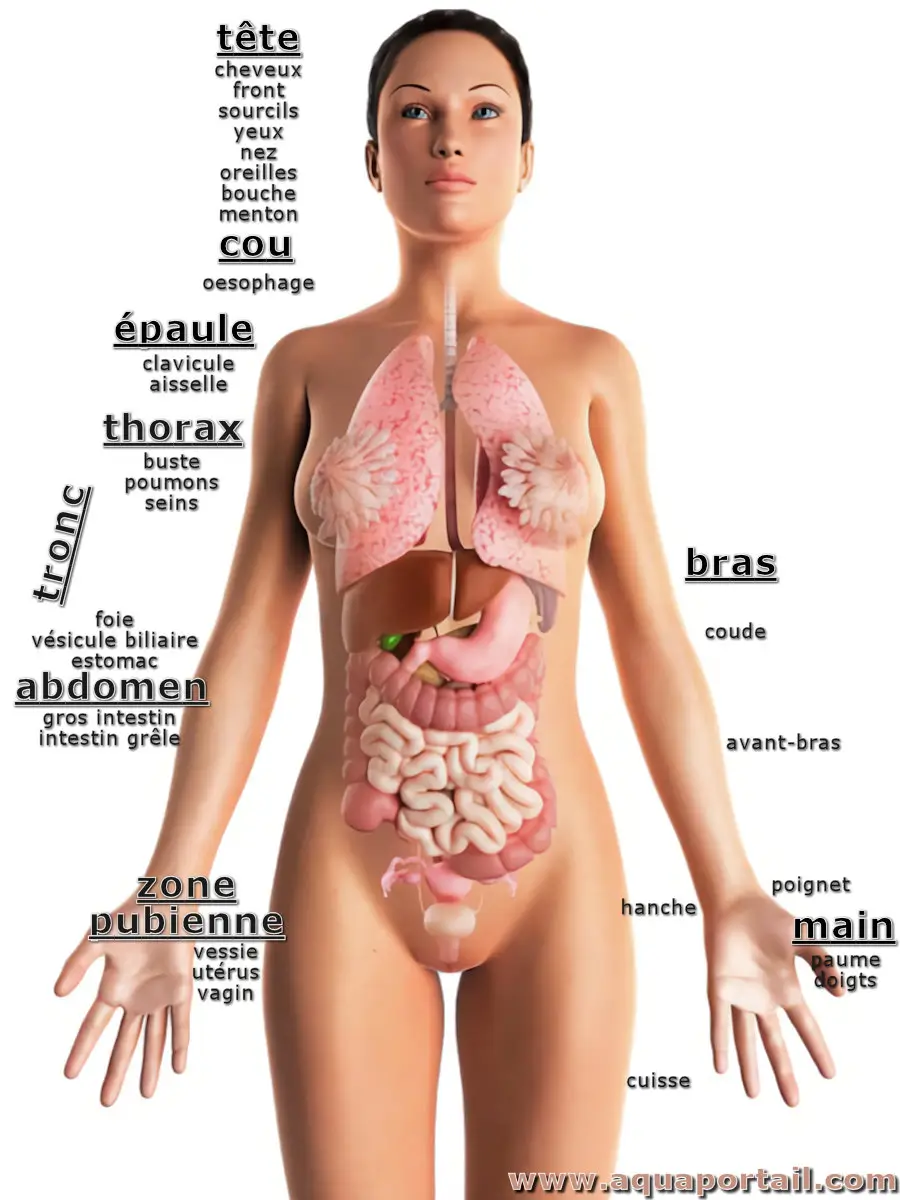

L'anatomie d'une femme reprend l'anatomie humaine avec les spécificités féminines que sont les organes reproducteurs, des seins allaitants plus développés...

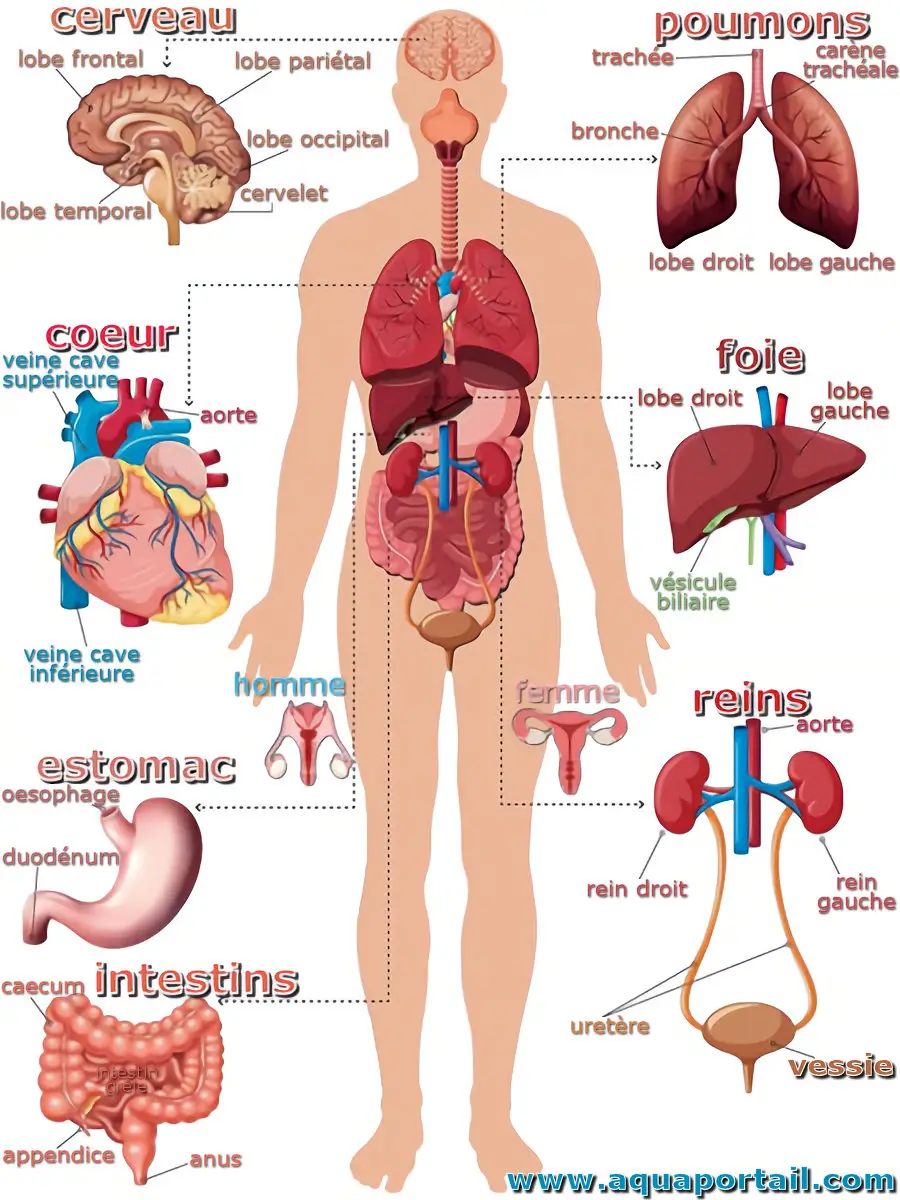

L'anatomie humaine est la science descriptive de la morphologie, des organes, des tissus et des systèmes fonctionnels du corps de Homo sapiens.

L'anatomie végétale est l'étude des tissus et de la structure cellulaire des organes végétaux, la structure interne des plantes.

La description anatomique, ou l'anatomie descriptive dans le domaine des sciences biologiques, concerne l'identification et la description des structures...